「人とコンピュータの間で『あうんの呼吸』を実現したい」

メディア学部 教授 相川 清明

■先生の研究について教えてください。

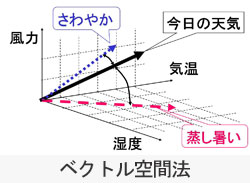

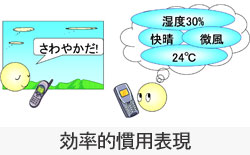

卒業研究プロジェクトでいうと、大きく分けて2つのことを研究しています。ひとつは「視聴覚特性とディジタル効果音」。これは人間の聴覚、つまり耳の不思議を探るという研究です。例えば、よく知られている曲「春の小川」を非常に速いピッチで流すと、人は聞き取れません。何の曲かわからないのです。聞いた曲に16個の音符があれば、速く流すとそのうちの8個くらいしか聞き取れていません。というように、人間の耳はかなりいい加減なんですよね(笑)。また、視覚と聴覚との関係も研究しています。AとBの映像のうち、音とぴったり合っているのはどちらか?という実験があります。実はどちらの映像も音とずれています。Aは音が映像よりも5分の1秒ほど速く出て、Bは映像が音より5分の1秒ほど速く出ています。しかし脳の中では、情報量の多い映像に処理の時間がかかるため、Bの少しでも映像が速く出たパターンの方が音とぴったり合ったと感じるのです。それからもうひとつの研究分野は「音と音声によるインタラクション」。コンピュータと人がスムーズに会話をするための研究をしています。具体的には、コンピュータから人に情報を伝えるとき、どういう表現をすれば一番うまく伝わるかという研究です。実は人間同士は、非常にうまく対話をしているんですよ。例えば「今日は、さわやかだね」というと、だいたい湿度が低くて、天気が良くて、気温もそれほど高くないということがわかります。これだけの情報を「さわやかだ」という直感的な言葉だけで伝えているのです。このように人間同士の非常に効率的な対話をコンピュータでも実現したいと思い、研究に取り組んでいます。

■コンピュータと人の対話で、これまでに開発されたものはありますか?

「ウェザーリポーター」というお天気案内システムがあります。これはベクトル空間法を用いたもので、気温や湿度、天気などの数値を組み合わせることで、あるときは“さわやかだ”と表現したり、あるときは“蒸し暑い”と表現したりするシステムです。つまり今日の天気をセンサーで測定して、それをどういう情報(言葉)で表現したら良いかをコンピュータが考えて話すというものです。また、この研究をベースにして、「香りを語るコンピュータ」というものをコンピュータサイエンス学部の三田地成幸教授と共同で開発しました。これはバラの香りをセンサーが検知し、コンピュータに取り入れて解析するとバラの種類を音声で答えるというシステムです。本学園の理事長がバラ好きということもあって、キャンパスにはいくつもバラがありますからね。それらの香りを事前にセンサーで測定し、情報として取り込み、そのデータベースと新たにセンサーで測定したバラの香りを照合して種類を当てるというものです。また、センサーで得た情報から例えばコンピュータが、カトリーヌ・ドヌーブというバラの可能性98%、マリアカラスというバラの可能性90%だと判断すると、音声は「カトリーヌ・ドヌーブみたい。だけどマリアカラスかもしれない」と話すんです。どうでしょうか? 数値を言われるよりも、使い慣れた表現で伝えられた方がわかりやすいですよね?

■確かにそうですね。あいまいな表現でも、そちらの方がよくわかります。

その“情報を人にわかりやすく伝える”という工夫をしたところが、この研究のポイントなのです。将来的には、この研究はロボットに活かせるのではないかと考えています。「今日は雨の確率何%」なんて言うロボットよりも、「今日は午後から雨かもしれない」と言うロボットの方がずっと身近に感じられ、人にわかりやすく情報を伝えますよね。ですから、近い将来、ロボットと人間が非常に効率良く、スムーズに対話するときの技術として使えればという思いを持っています。

■こうした研究で苦労される点とはどのようなことでしょうか?

どういう要素の組み合わせにしたら良いかというところですね。例えば、蒸し暑さを表現するには、「温度」と「湿度」という要素が必要です。もし「湿度」の項目がなくなると、“蒸し暑さ”は表現できません。もっと言えば、“さわやかだ”ということを表現しようと思うと、「温度」と「湿度」だけでは足りなくて、天気の良し悪しや風の有無も関係してきます。このように、どういう基本的な要素を項目として持ってくれば、感性をうまく表現できるのかというところが難しいです。

■では今後の展望をお聞かせください。

「香りを語るコンピュータ」については、センサーの精度を高めて、もっといろいろな種類の香りを検出できるようにしたいですね。今のセンサーは2種類の香り成分を検出し、その組み合わせでさまざまな表現をしているのですが、もう少し多様な種類が欲しいと思っています。また、次の展開としては、冷蔵庫に同じ仕組みを取り入れて、「お魚が腐りそうですよ」といったお知らせができないかと考えています。ガス漏れの警報器としても使えそうですね。そんなふうに身近なところで活用できればと思います。それから、感性による情報検索の研究も進めていくつもりです。実際に、感性キーワードを使って音楽を検索するという研究に取り組んでいます。今までの音楽検索は、アーティスト名や音楽のジャンル、曲名というもので検索してきました。でもそうした方法ではなく、「ちょっと悲しげな曲」といった人間の感情表現で音楽を探すことができないかと考えています。現在は「楽しさ」「明るさ」「不気味さ」など、8つのキーワードを人が選ぶことで、データベースから曲を探してくれる検索システムを開発中です。ただ、データベースに入っている曲が悲しいのか明るいのかといった基本的な情報は、最初に人間が入力しておくしかありません。そこで今は、そうした基本情報を音の特徴から自動的に導き出そうと試みています。例えばテンポの速い遅いや激しさといった、その曲が持っている特徴から8つのキーワードを導き出すというものです。これに成功すれば、どんな曲を持ってきても、それがどういう曲かをすぐに分析できるので、いくらでも検索する音源を増やすことができます。また、もっと大きな、研究者としての展望では、生物が持っている不思議な機能や働きを解明したいと思っています。特に感覚器は、生物の持つ不思議なものの中でも頂点に立ちます。その働きを解明することが、長年、私の抱いている夢なのです。

[2009年1月取材]

■所属研究室・プロジェクト紹介

感性の表現

https://www.teu.ac.jp/info/lab/project/media_dep/7.html

インタラクション分析とモデル化

https://www.teu.ac.jp/info/lab/project/media_dep/17.html

ディジタル効果音

https://www.teu.ac.jp/info/lab/project/media_dep/27.html

インテリジェント・エージェント・プロジェクト

https://www.teu.ac.jp/info/lab/project/media_spc/110.html

スーパー効果音プロジェクト

https://www.teu.ac.jp/info/lab/project/media_spc/120.html

メディア・トランスデューサ・プロジェクト

https://www.teu.ac.jp/info/lab/project/media_spc/130.html

・次回は3月13日に配信予定です。